Statistiques de multicolinéarité

Qu’est-ce que la multicolinéarité ?

On dit que des variables sont multicolinéaires s'il existe une relation linéaire entre elles. C'est une extension du cas simple de la colinéarité entre deux variables. Par exemple, pour trois variables X1, X2, X3, on dira qu'elles sont multicolinéaires si on peut écrire

X1 = aX2 + bX3

où a et b sont deux nombres réels.

Comment détecter la multicolinéarité ?

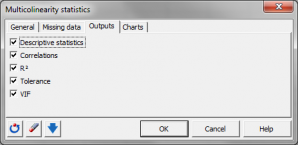

Pour détecter les multicolinéarités et identifier les variables impliquées dans des multicolinéarités, on effectue des régressions linéaires de chacune des variables en fonction des autres. On calcule ensuite :

- Le R² de chacun des modèles. Si le R² vaut 1, alors il existe une relation linéaire entre la variable dépendante du modèle (le Y) et les variables explicatives (les X).

- La tolérance pour chacun des modèles. La tolérance vaut (1-R²). Elle est utilisée dans plusieurs méthodes (régression linéaire, régression logistique, analyse factorielle discriminante) comme un critère de filtrage des variables. Si une variable a une tolérance inférieure à un seuil fixé (la tolérance est calculée en prenant en compte les variables déjà utilisées dans le modèle), on ne la laisse pas entrer dans le modèle car sa contribution est négligeable et elle risquerait d'entraîner les problèmes numériques.

- Le VIF. Le VIF ou Variance Inflation Factor qui est égal à l'inverse de la tolérance.

Pourquoi détecter la multicolinéarité ?

Il peut être utile de détecter des multicolinéarités au sein d'un groupe de variables notamment dans les cas suivants :

- pour identifier des structures dans les données et en tirer des décisions opérationnelles (par exemple, arrêter de mesurer une variable sur une chaîne de fabrication car elle est fortement liée à d'autres qui sont aussi mesurées) ;

- pour éviter des problèmes numériques lors de certains calculs. Certaines méthodes utilisent des inversions de matrices. L'inverse d'une matrice (p x p) ne peut être calculé que si elle est de rang p (ou régulière). Si elle est de rang inférieur, autrement dit s'il existe des relations linéaires entre ses colonnes, alors elle est singulière et non inversible.

- Lorsqu’une régression linéaire multiple est exécutée sur des variables explicatives multicolinéaires, les estimations des coefficients peuvent être incorrectes. La fonctionnalité XLSTAT-régression linéaire permet de calculer automatiquement les statistiques de multicolinéarité sur les variables explicatives. Ainsi, l’utilisateur peut choisir d’éliminer les variables explicatives trop redondantes avec les autres. Notons que la régression PLS n'est pas sensible à la multicolinéarité. Cependant, cette méthode est surtout utilisée à des fins de prédiction, et non pas pour des estimations de coefficients.

analysez vos données avec xlstat

essayez gratuitement pendant 14 jours

Fonctionnalités corollaires