Analyse Factorielle Discriminante (AFD)

L'Analyse Factorielle Discriminante est une méthode statistique explicative et prédictive mettant en jeu une variable à expliquer qualitative. Disponible dans Excel avec XLSTAT.

Qu’est-ce que l’Analyse Factorielle Discriminante ?

L'Analyse Factorielle Discriminante (AFD) est une méthode ancienne (Fisher, 1936) qui dans sa version classique a peu évolué au cours des vingt dernières années. Cette méthode, à la fois explicative et prédictive, peut être utilisée pour :

- vérifier sur un graphique à deux ou trois dimensions si les groupes auxquels appartiennent les observations sont bien distincts,

- identifier quelles sont les caractéristiques des groupes sur la base de variables explicatives,

- prédire le groupe d'appartenance pour une nouvelle observation.

Les applications possibles de l'AFD sont très nombreuses de l'écologie à la prévision de risque en finance (crédit scoring).

Analyse Factorielle Discriminante Linéaire Versus Quadratique

Deux modèles d'Analyse Factorielle Discriminante sont possibles en fonction d'une hypothèse fondamentale :

- L'Analyse Factorielle Discriminante Linéaire : si l'on suppose que les matrices de covariance sont identiques.

- L'Analyse Factorielle Discriminante Quadratique : si l'on suppose au contraire que les matrices de covariance sont différentes pour au moins deux groupes. Le test de Box permet de tester cette hypothèse (l'approximation de Bartlett permet d'utiliser une loi du Khi² pour le test). On peut commencer par une analyse linéaire, puis, en fonction des résultats du test de Box éventuellement faire une analyse quadratique.

Note: L'analyse discriminante est étroitement liée à l'analyse multivariée de la variance (MANOVA) .

Analyse Factorielle Discriminante et problèmes de multicollinéarité

Dans le cas du modèle linéaire et encore plus dans le cas du modèle quadratique on peut faire face à des problèmes de variables ayant une variance nulle ou de multicolinéarité entre variables. XLSTAT a été programmé de manière à éviter ces problèmes. Les variables responsables de tels problèmes sont automatiquement ignorées soit pour l'ensemble des calculs, soit, dans le cas du modèle quadratique, pour les groupes pour lesquels les problèmes se posent. Les statistiques de multicolinéarité sont optionnellement affichées afin de vous permettre d'identifier les variables sources de problèmes.

Analyse Factorielle Discriminante et sélection de variables

Comme pour la régression linéaire et logistique, des méthodes pas à pas efficaces ont été proposées. Elles ne sont toutefois utilisables que lorsque seules des variables quantitatives sont sélectionnées car les tests d'entrée et sortie de variables s'appuient sur une hypothèse de normalité des variables. La méthode stepwise (pas à pas progressive) permet d'obtenir un modèle performant évitant les variables qui n'apportent que peu d'information au modèle.

Analyse discriminante et régression logistique

Dans le cas où il n'y a que deux classes à prédire pour la variable dépendante, l'analyse discriminante est très proche de la régression logistique. L'analyse discriminante présente l'intérêt d'étudier dans le détail les structures de covariance, et d'aboutir à une représentation graphique. La régression logistique présente quant à elle l'avantage d'offrir plusieurs formes modèles possibles, et de permettre l'utilisation des méthodes de sélection pas à pas y compris pour les variables explicatives qualitatives. L'utilisateur pourra comparer les performances des deux méthodes en s'appuyant sur les courbes ROC.

Options de la fonctionnalité Analyse Factorielle Discriminante dans XLSTAT

Egalité des matrices de covariance : activez cette option si vous souhaitez faire l'hypothèse que les matrices de covariance associées aux différentes classes de la variable dépendante sont égales (AFD linéaire) ou inégales (AFD quadratique).

Probabilités a priori : activez cette option pour prendre en compte les probabilités a priori. Les probabilités associées à chacune des classes sont égales à la fréquence des classes. Remarque : cette option est sans effet si les probabilités a priori sont égales pour les différents groupes.

Filtrer les facteurs : vous pouvez activer l'une ou les deux options suivantes afin de réduire le nombre de facteurs pour lesquels les résultats sont affichés :

% minimum : activez cette option puis saisissez le pourcentage minimum de la variabilité totale que doivent représenter les facteurs retenus.

Nombre maximum : activez cette option pour fixer le nombre maximum de facteurs à prendre en compte.

Niveau de signification (%) : entrez le niveau de signification pour les différents tests calculés.

Sélection du modèle : activez cette option si vous souhaitez utiliser l'une des quatre méthodes de sélection proposées :

Stepwise (Ascendante) : le processus de sélection commence par l'ajout de la variable ayant la plus forte contribution au modèle. Si une seconde variable est telle que sa probabilité d'entrée est supérieure à la valeur seuil pour entrer, alors elle est ajoutée au modèle. A partir de l'ajout de la troisième variable, après chaque ajout, on évalue pour toutes les variables présentes dans le modèle quel serait l'impact de son retrait. Si la probabilité de la statistique calculée est supérieure à la valeur seuil pour retirer, la variable est retirée du modèle.

Stepwise (Descendante) : cette méthode est similaire à la précédente, mais part d'un modèle complet.

Ascendante : la procédure est identique à cette de la sélection progressive, hormis le fait que les variables sont uniquement ajoutées et jamais retirées.

Descendante : la procédure commence par l'ajout simultané de toutes les variables. Les variables sont ensuite retirées du modèle suivant la procédure utilisée pour la sélection progressive.

Correction du poids des classes : si les effectifs des différentes classes de la variable dépendante ne sont pas homogènes, on risque de pénaliser dans l'établissement du modèle les classes ayant un faible effectif. Afin de palier ce problème, XLSTAT propose deux options :

Automatique : le redressement est automatique. Des des poids artificiels sont affectés aux observations dans le but d'obtenir des classes dont la somme des poids est identique.

Poids correctifs : vous pouvez sélectionner les poids à affecter à chacune des observations.

Validation : activez cette option si vous souhaitez utiliser une partie des données sélectionnées pour valider le modèle.

Résultats de la fonctionnalité Analyse Factorielle Discriminante dans XLSTAT

Tableau de classification, courbe ROC et validation croisée :

Parmi les nombreux résultats proposés, XLSTAT donne la possibilité d'afficher le tableau de classification (aussi appelé matrice de confusion) qui permet de calculer un pourcentage d'observations bien classées. Lorsque seules deux classes (ou catégories, ou modalités) sont présentes dans la variable dépendante, la courbe ROC peut aussi être affichée. La courbe ROC (Receiver Operating Characteristics) permet de visualiser la performance d'un modèle, et de la comparer cette performance à celle d'autres modèles. Les termes utilisés viennent de la théorie de détection du signal.

On désigne par sensibilité (sensivity) la proportion d'événements positifs bien classés. La spécificité (specificity) correspond à la proportion d'événements négatifs bien classés. Si l'on fait varier la probabilité seuil à partir de laquelle on considère qu'un événement doit être considéré comme positif, la sensibilité et la spécificité varient. La courbe des points (1-spécificité, sensibilité) est la courbe ROC. Considérons une variable dépendante binaire indiquant par exemple si un client a répondu favorablement à un mailing. Sur la figure ci-dessous, la courbe bleue correspond à un cas idéal où les n% de personnes ayant répondu favorablement correspondent aux n% de probabilités les plus élevées. La courbe verte correspond aux résultats d'un modèle bien discriminant. La courbe rouge (première bissectrice) correspond à ce que l'on obtiendrait avec un modèle aléatoire de Bernoulli avec une probabilité de réponse égale à celle observée sur l'échantillon étudié. Un modèle proche de la courbe rouge est donc inefficace puisqu'il n'est pas meilleur qu'un simple tirage au hasard. Un modèle en dessous de cette courbe serait catastrophique car il ferait moins bien que le hasard.

L'aire sous la courbe (ou Area Under the Curve – AUC) est un indice synthétique calculé pour les courbes ROC. L'AUC correspond à la probabilité pour qu'un événement positif ait une probabilité donnée par le modèle plus élevée qu'un événement négatif. Pour un modèle idéal, on a AUC=1, pour un modèle aléatoire, on a AUC=0.5. On considère habituellement que le modèle est bon dès lors que la valeur de l'AUC est supérieure à 0.7. Un modèle bien discriminant doit avoir une AUC entre 0.87 et 0.9. Un modèle ayant une AUC supérieure à 0.9 est excellent.

Les résultats du modèle en termes de prévision peuvent être trop optimistes : en effet, on cherche à vérifier si une observation est bien classée, alors qu'elle-même est prise en compte pour le calcul du modèle. Pour cette raison a été développée la validation croisée : pour déterminer la probabilité d'appartenance d'une observation aux différents groupes, on la retire de l'échantillon d'apprentissage, puis on calcule le modèle et la prévision. Cette opération est répétée pour chacune des observations de l'échantillon d'apprentissage. Les résultats ainsi obtenus sont plus représentatifs de la qualité du modèle.

Moyennes par classe : ce tableau fournit les moyennes des différentes variables explicatives pour les différentes classes de la variable dépendante.

Somme des poids, probabilités a priori et log des déterminants pour chaque classe : ces statistiques sont utilisées entre autres dans les calculs des probabilités a posteriori pour les observations.

Statistiques de multicolinéarité : ce tableau permet d'identifier les variables responsables de multicolinéarités entre les variables. Dès qu'une variable est détectée comme étant responsable d'une multicolinéarité (sa tolérance est inférieure à la tolérance limite fixée dans l'onglet « options » de la boîte de dialogue), elle n'est pas prise en compte pour le calcul des statistiques de multicolinéarité des variables suivantes. Ainsi dans un cas extrême où deux variables seraient identiques, seule l'une des deux variables sera éliminée des calculs. Les statistiques affichées sont la tolérance (égale à 1-R²), et son inverse, le VIF (Variance inflation factor).

Matrices SSCP : les matrices SSCP (Sums of Squares and Cross Products) sont proportionnelles aux matrices de covariance. Elles interviennent dans les calculs et vérifient la relation suivante : SSCP totale = SSCP inter + SSCP intra totale.

Matrices de covariance : sont successivement affichées la matrice de covariance inter-classes, égale à la matrice de covariance sans biais des moyennes des différentes classes, la matrice de covariance intra-classe de chacune des classes (sans biais), la matrice de covariance intra-classe totale qui est une somme pondérée des précédentes, et la matrice de covariance totale calculée sur la totalité des observations (sans biais).

Synthèse de la sélection des variables : dans le cas où une méthode de sélection a été choisie, XLSTAT affiche la synthèse de la sélection. Dans le cas d'une sélection pas à pas (stepwise), Ascendante ou Descendante, les statistiques correspondant aux différentes étapes sont affichées.

Test de Box : le test de Box permet de tester l'hypothèse d'égalité des matrices de covariance intra-classe. Deux approximations ont été proposées, l'une basée sur la distribution du Khi², l'autre sur la distribution de Fisher. Les résultats des deux tests sont affichés.

Test de Kullback : le test de Kullback permet de tester l'hypothèse d'égalité des matrices de covariance intra-classe. La statistique calculée est approximativement distribuée suivant une loi du Khi².

Distances de Mahalanobis : la distance de Mahalanobis permet de mesurer la distance entre les classes en tenant compte de la structure de covariance. Dans le cas où l'on suppose les matrices de variance intra-classe égales, la matrice des distances est calculée en utilisant la matrice de covariance intra-classe totale.

Distances de Fisher : dans le cas de l'hypothèse d'égalité des matrices de covariance, les distances de Fisher entre les classes sont affichées. Elles sont calculées à partir de la distance de Mahalanobis et permettent un test de significativité. La matrice des p-values est affichée afin de permettre de repérer quelles distances sont significatives.

Distances quadratiques généralisées : dans le cas où l'on ne fait pas l'hypothèse d'égalité des matrices de covariance, le tableau des distances quadratiques généralisées entre les classes est affiché. La distance généralisée est aussi calculée à partir des distances de Mahalanobis et tient compte des logarithmes des déterminants des matrices de covariance ainsi que des logarithmes des probabilités a priori si requis par l'utilisateur.

Test du Lambda de Wilks (approximation de Rao) : ce test permet de tester l'hypothèse d'égalité des vecteurs moyens des différentes classes. Si lorsqu'il y a deux classes le test est équivalent au test de Fisher mentionné ci-dessus. Si le nombre de classes est inférieur ou égal à trois, le test est exact. L'approximation de Rao est nécessaire à partir de quatre classes pour obtenir une statistique approximativement distribuée suivant une loi de Fisher.

Test unidimensionnel d'égalité des moyennes des classes : ces tests permettent de tester variable par variable l'hypothèse d'égalité des moyennes entre les classes. Le lambda de Wilks univarié est toujours compris entre 0 et 1. Une valeur de 1 correspond au cas où les moyennes des classes sont égales. Une valeur faible s'interprète comme de faibles variations intra-classe et donc de fortes variations inter-classes, d'où une différence significative des moyennes des classes.

Trace de Pillai : ce test permet de tester l'hypothèse d'égalité des vecteurs moyens des différentes classes. Il est moins utilisé que le test du Lambda de Wilks et utilise aussi la loi de distribution de Fisher pour le calcul des p-values.

Trace de Hotelling-Lawley : ce test permet de tester l'hypothèse d'égalité des vecteurs moyens des différentes classes. Il est moins utilisé que le test du Lambda de Wilks et utilise aussi la loi de distribution de Fisher pour le calcul des p-values.

Plus grande racine de Roy : ce test permet de tester l'hypothèse d'égalité des vecteurs moyens des différentes classes. Il est moins utilisé que le test du Lambda de Wilks et utilise aussi la loi de distribution de Fisher pour le calcul des p-values.

Valeurs propres : dans ce tableau sont affichées les valeurs propres associées aux différents facteurs, ainsi que les pourcentages et pourcentages cumulés de discrimination correspondant. En analyse discriminante, le nombre de valeurs propres non nulles est au plus égal à (k-1) où k est le nombre de classes. Le scree plot permet de visualiser comment le pouvoir discriminant est réparti entre les facteurs discriminants. La somme des valeurs propres est égale à la trace de Hotelling.

Vecteurs propres : dans ce tableau sont affichées les vecteurs propres qui interviennent ensuite dans le calcul des corrélations canoniques, des coefficients des fonctions canoniques et des coordonnées des observations (scores).

Corrélations Variables/Facteurs : le calcul des corrélations entre les coordonnées des observations dans l'espace des variables initiales et dans l'espace des facteurs discriminants permet de visualiser sur un cercle des corrélations la relation entre les variables de départ et les facteurs. Le cercle des corrélations est une aide à l'interprétation de la représentation des observations dans l'espace des facteurs.

Corrélations canoniques : les corrélations canoniques associées à chaque facteur sont les racines carrés des quantités L(i) / (1- L(i)) où L(i) est la valeur propre associée au facteur i. Les corrélations canoniques sont aussi une mesure du pouvoir discriminant des facteurs. Leur somme est égale à la trace de Pillai.

Coefficients des fonctions discriminantes canoniques : ces coefficients peuvent être utilisés pour calculer les coordonnées d'une observation dans l'espace des facteurs discriminants à partir de ses coordonnées dans l'espace des variables initiales.

Coefficients standardisés des fonctions discriminantes canoniques : ces coefficients correspondent aux précédents mais sont standardisés. Ainsi leur comparaison permet de mesurer la contribution relative des variables initiales à la discrimination pour un facteur donnée.

Fonctions aux barycentres : ce tableau donne l'évaluation des fonctions discriminantes pour les points moyens pour chacune des classes.

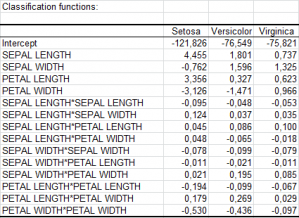

Fonctions de classement : les fonctions de classement peuvent être utilisées pour déterminer à quelle classe doit être affectée une observation sur la base des valeurs prises pour les différentes variables explicatives. Dans le cas de l'hypothèse d'égalité des matrices de covariance, ces fonctions sont linéaires. Dans le cas de l'hypothèse d'inégalité des matrices de covariance, ces fonctions sont quadratiques. Une observation est affectée à la classe pour laquelle la fonction de classement est la plus élevée.

Classification a priori, probabilités, coordonnées et carrés des distances : dans ce tableau sont affichés pour chaque observation, sa classe d'appartenance définie par la variable dépendante, la classe d'appartenance telle que déduite des probabilités d'appartenance, les probabilités d'appartenance à chacune des classes, les coordonnées dans l'espace des facteurs discriminants, et les carrés des distances des observations aux barycentres de chacune des classes.

Matrice de confusion pour l'échantillon d'estimation : des classifications a priori et a posteriori est déduite la matrice de confusion, ainsi que le pourcentage global d'observations biens classées. Dans le cas où la variable dépendante ne comprend que deux classes la courbe ROC est affichée (voir la section description pour plus détails).

Validation croisée : dans le cas où une validation croisée a été demandée, le tableau contenant les informations pour les observations et la matrice de confusion sont affichés.

Analyse Factorielle Discriminante : Graphiques dans XLSTAT

- Graphiques de corrélations : activez cette option pour afficher les graphiques mettant en jeu des corrélations entre des composantes et des variables initiales.

Vecteurs : activez cette option pour afficher les variables d'origine sous forme de vecteurs.

- Graphiques des observations : activez cette option pour afficher les graphiques de représentation des observations dans le nouvel espace.

Etiquettes : activez cette option pour afficher les étiquettes des observations sur les graphiques. Le nombre d'étiquettes affichées peut être modulé à l'aide de l'option de filtrage.

Afficher les barycentres : activez cette option pour afficher les barycentres correspondant aux modalités de la variable dépendante.

Ellipses de confiance : activez cette option pour afficher des ellipses de confiance. Les ellipses de confiance correspondent à un intervalle de confiance à x% (x est déterminé à partir du niveau de signification spécifié dans l'onglet général) pour une loi normale bivariée de mêmes moyennes et de même matrice de covariance que les données factorielles correspondant aux différentes modalités de la variable dépendante.

- En fonction de l'hypothèse : activez cette option pour faire le calcul des ellipses sur la base de l'hypothèse que les matrices de covariance sont égales ou non. Si l'option est désactivée les ellipses sont calculées sans faire l'hypothèse que les matrices de covariance sont égales, quelque soit l'hpyothèse choisie dans l'onglet Options.

- Barycentres et cercles : activez cette option pour afficher le graphique des barycentres avec les cercles de confiance autour des moyennes.

Analyse Factorielle Discriminante : tutoriel dans XLSTAT

Ce tutoriel vous aidera à configurer et interpréter une Analyse Factorielle Discriminante dans Excel avec XLSTAT.

analysez vos données avec xlstat

Fonctionnalités corollaires