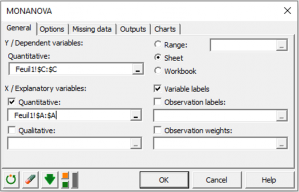

MONANOVA - Régression monotone

Principe de la régression monotone MONANOVA

La régression monotone et la méthode MONANOVA diffèrent uniquement dans le fait que les variables explicatives sont soit quantitatives, soit qualitatives. Ces méthodes sont basées sur des algorithmes itératifs issus de l’algorithme ALS (moindres carrés alternés). Leur principe est simple, il consiste en l’alternance entre une estimation classique du type régression linéaire ou ANOVA et d’une transformation monotone des variables dépendantes (issue des recherches sur l’optimal scaling).

L’algorithme MONANOVA a été présenté par Kruskal (1965). Les méthodes de régression monotone et les travaux sur l’algorithme ALS sont quant à eux dus à Young et al. (1976).

Ces méthodes sont utilisées couramment dans le cadre de l’analyse conjointe basée sur les profils complets. XLSTAT-Conjoint permet de les appliquer à l’intérieur d’une analyse conjointe mais aussi de manière indépendante.

L’outil régression monotone (MONANOVA) permet de combiner une transformation monotone des réponses à une régression linéaire de manière à améliorer les résultats de la régression.

XLSTAT-Conjoint permet d’ajouter des interactions et de faire varier les contraintes sur les variables qualitatives.

Algorithme de ma régression monotone MONANOVA

La régression monotone combine une étape de régression linéaire ordinaire entre les variables explicatives et la variable réponse et une étape de transformation de la variable réponse de manière à optimiser la qualité de prédiction.

L’algorithme du type moindres carrés alternés est le suivant :

- Régression OLS entre la variable réponse Y et les variables explicatives X. On obtient les coefficients béta.

- Calcul des valeurs prédites de Y avec le modèle obtenu Pred(Y)=beta*X

- Transformation de Y en utilisant une transformation monotone (Kruskal, 1965) de façon à ce que Pred(Y) et Y soient proches (utilisation de l’optimal scaling).

- Régression OLS entre Ytrans et les variables explicatives X. On obtient de nouvelles valeurs pour les béta.

- Les étapes 2 à 4 sont répétées jusqu’à ce que la variation du R² d’une étape à l’autre soit plus petite que le critère de convergence.

Coefficients d’ajustement (MONANOVA)

Dans le cadre d’une régression monotone, des résultats supplémentaires sont disponibles.

Ces résultats sont généralement associés à une analyse multivariée mais comme nous sommes dans le cas d’une transformation leur présence est aussi nécessaire. Au lieu d’utiliser le carré des corrélations canoniques entre les mesures, nous utilisons le R² entre la mesure et sa transformation car il y a une seule transformation linéaire.

Ainsi, XLSTAT-Conjoint calcule le lambda de Wilks, la trace de Pillai, le trace de Hotelling-Lawlet et la plus grande racine de Roy en utilisant une matrice avec comme plus grande valeur propre le R² et 0 pour les autres. La plus grande racine de Roy donne une borne inférieure pour la p-valeur. Les autres indices donnent des bornes supérieures à la p-valeur du modèle.

analysez vos données avec xlstat

Inclus dans