Test non-paramétrique sur k échantillons indépendants: test de Kruskal-Wallis

Quand utiliser le test de Kruskal-Wallis ?

Le test de Kruskal-Wallis est un test non paramétrique à utiliser lorsque vous êtes en présence de k échantillons indépendants, afin de déterminer si les échantillons proviennent d'une même population ou si au moins un échantillon provient d'une population différente des autres.

Le test de Kruskal-Wallis est souvent utilisé comme une alternative à l'ANOVA dans le cas où l'hypothèse de normalité n'est pas acceptable. Il permet de tester si k échantillons (k>2) proviennent de la même population, ou de populations ayant des caractéristiques identiques, au sens d'un paramètre de position (le paramètre de position est conceptuellement proche de la médiane, mais le test de Kruskal-Wallis prend en compte plus d'information que la position au seul sens de la médiane).

Principe du test de Kruskal-Wallis

Si on désigne par Mi le paramètre de position l'échantillon i, les hypothèses nulle H0 et alternative Ha du test de Kruskal-Wallis sont les suivantes :

- H0 : M1 = M2 = … = Mk

- Ha : il existe au moins un couple (i, j) tel que Mi ≠ Mj

Le calcul de la statistique K du test de Kruskal-Wallis fait intervenir comme pour le test de Mann-Whitney le rang des observations, une fois les k échantillons (ou groupes) mélangés. K est défini par :

K = 12/(N(N+1)) Σi=1..k [Ri²-3(N+1)]

où ni est la taille de l'échantillon i, N la somme des ni, et Ri la somme des rangs pour l'échantillon i parmi l'ensemble des échantillons. Lorsque k=2 le test de Kruskal-Wallis est équivalent au test de Mann-Whitney, et la statistique K est équivalente à la statistique Ws. Lorsqu'il y a des ex aequo, on utilise les rangs moyens pour les observations correspondantes, comme dans le cas du test de Mann-Whitney.

Calcul de la p-value du test de Kruskal-Wallis

Pour le calcul de la p-value associée à une valeur donnée de K, XLSTAT propose trois alternatives :

- Méthode asymptotique : la p-value est obtenue grâce à une approximation de la loi de K par une loi du Khi² à (k-1) degrés de liberté. Cette approximation est fiable, sauf lorsque N est petit.

- Méthode exacte : le calcul de la p-value exacte repose sur la distribution réelle de K. Ce calcul est très intensif numériquement.

- Méthode Monte Carlo : ce calcul est basé sur un rééchantillonnage aléatoire. L'utilisateur doit choisir le nombre de simulations (ou rééchantillonnages) à réaliser. Un intervalle de confiance autour de la p-value obtenue est fourni. Cet intervalle sera bien entendu d'autant plus resserré que le nombre de simulations est important.

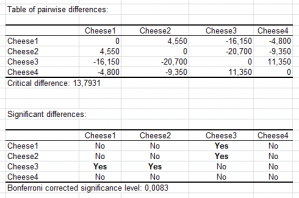

Si la p-value est telle que l'on doit rejeter l'hypothèse H0, alors au moins un échantillon (ou groupe) est différent d'un autre. Afin d'identifier quels échantillons sont responsables du rejet de H0, il est possible d'utiliser une procédure de comparaisons multiples.

Pour le test de Kruskal-Wallis trois méthodes de comparaisons multiples sont proposées :

- Dunn (1963) : propose une méthode basée sur la comparaison des moyennes des rangs, ces derniers étant ceux utilisés pour le calcul du K, en utilisant une distribution normale asymptotique pour la différence standardisée de la moyenne des rangs.

- Conover et Iman(1999) : proche de la méthode de Dunn, cette méthode utilise une distribution de Student. Elle correspond à un test de Student réalisé sur les rangs.

- Steel-Dwass-Critchlow-Fligner (1984) : cette méthode, plus complexe mais recommandée par Hollander (1999), nécessite le recalcul des rangs pour chaque combinaison deux à deux des échantillons. La statistique Wij est calculée pour chaque combinaison. XLSTAT calcule ensuite la p-value correspondante en utilisant la distribution asymptotique de la statistique.

analysez vos données avec xlstat

Fonctionnalités corollaires