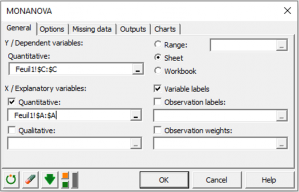

Monotone Regression (MONANOVA)

Die monotone Regression und die MONANOVA Methode unterschieden sich lediglich in der Tatsache, dass die erklärenden Variablen einerseits quantitativ und andererseits qualitativ sind. Diese Methoden basieren auf Algorithmen, die sich aus dem Algorithmus ALS (alternierende kleinste Quadrate) entwickelt haben. Ihr Prinzip ist einfach. Es besteht aus einem Abwechseln zwischen einer klassischen Schätzung von Typ der linearen Regression oder der ANOVA und einer monotonen Transformation der abhängigen Variablen (auf Basis der Ergebnisse der optimalen Skalierung) andererseits. Der MONANOVA Algorithmus wurde von Kruskal (1965) vorgeschlagen und die Methoden der monotonen Regression sowie die Arbeiten über den ALS Algorithmus gehen auf Young et al. (1976) zurück.

Diese Methoden sind weit verbreitet im Rahmen der Conjoint-Analyse auf Basis von kompletten Profilen. XLSTAT-Conjoint erlaubt es, sie als Teil der Conjoint-Analyse anzuwenden (siehe auch das entsprechende Kapitel in der Conjoint-Analyse mit kompletten Profilen), aber ebenfalls unabhängig hiervon.

Das Tool der monotonen Regression (MONANOVA) erlaubt es, eine monotone Transformation der Antworten mit einer linearen Regression so zu verbinden, dass die Ergebnisse der Regression verbessert werden. XLSTAT-Conjoint erlaubt es, Interaktionen hinzuzufügen und die Beschränkungen für die qualitativen Variablen zu verändern.

Methode

Die monotone Regression kombiniert einen Schritt der gewöhnlichen linearen Regression zwischen den erklärenden Variablen und der Antwortvariablen mit einem Schritt der Transformation der Antwortvariablen in der Art und Weise, dass die Qualität der Vorhersage optimiert wird.

Der Algorithmus der alternierenden kleinsten Quadrate ist der folgende:

- 1- Regression OLS zwischen der Antwortvariablen Y und den erklärenden Variablen X. Man erhält die Beta-Koeffizienten.

- Berechnung der Vorhersagewerte für Y mit dem erhaltenen Modell Pred(Y)=beta*X

- Transformation der Y unter Einbezug einer monotonen Transformation (Kruskal, 1965) so dass Pred(Y) und Y nah beieinander liegen (Benutzen der optimalen Skalierung).

- Regression OLS zwischen Ytrans und den erklärenden Variablen X. Man erhält neue Werte für Beta.

- Die Schritte 2 bis 4 werden so lange wiederholt, bis die Veränderung des R² von einem Schritt zum nächsten kleiner als das Konvergenzkriterium ist.

Anpassungskoeffizienten (MONANOVA)

Im Rahmen einer monotonen Regression sind zusätzliche Ergebnisse verfügbar. Diese Ergebnisse gehören im Allgemeinen zu einer multivariaten Analyse. Da man sich jedoch m Fall einer Transformation befindet, sind diese hier ebenfalls notwendig. Anstatt des Quadrats der kanonischen Korrelationen zwischen den Werten, wird das R² zwischen den Werten und seiner Transformation benutzt, da nur eine einzige lineare Transformation vorliegt.

So berechnet XLSTAT-Conjoint Wilks Lambda, die Spur von Pillai, die Spur von Hotelling-Lawlet und die größte Wurzel von Roy, wobei eine Matrix mit dem größten Eigenwert R² und 0 für die übrigen benutzt wird. Die größte Wurzel von Roy gibt eine untere Schranke für den p-Value. Die übrigen Indizes geben obere Schranken für den p-Value des Modells.

analysieren sie ihre daten mit xlstat

Enthalten ind